Stable Diffusion,让可控开源生成更易用

在生产级界面中调用 SDXL/SD3 checkpoint、ControlNet、LoRA 与提示词权重,获得可复现的照片、风格化艺术或技术图。

Stable Diffusion 图像生成器

示例:看看 Nano Banana 能做什么1 / 9

处理前

处理后

使用的提示词:

"将衣橱拆解成各个组成部件。"

处理前

处理后

使用的提示词:

"将图像中的对象移除。"

处理前

处理后

使用的提示词:

"将比基尼颜色调整为鲜艳的红色。"

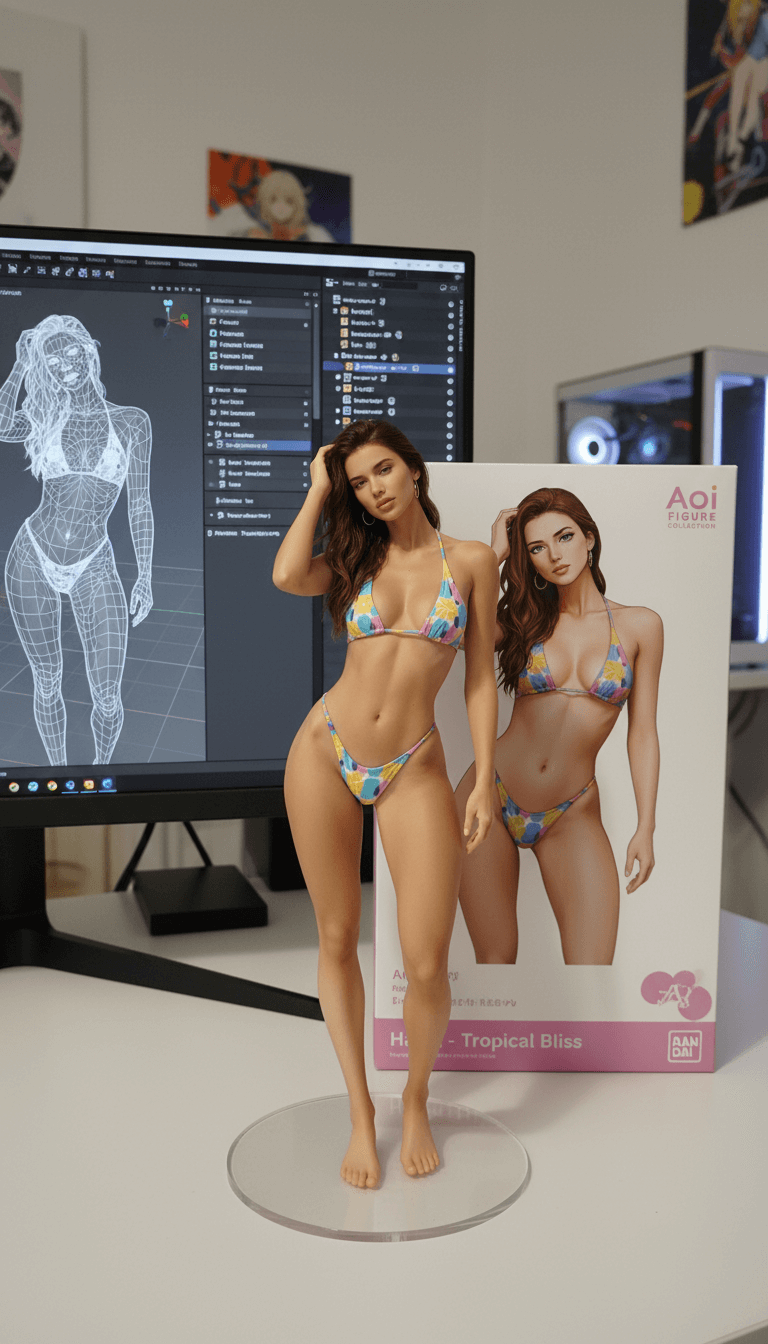

处理前

处理后

使用的提示词:

"将这个动漫角色打造成实体手办产品展示:让PVC手办站在透明圆形底座上,背后放置印有角色插画的包装盒,再加入展示 Blender 建模流程的显示器。"

处理前

处理后

使用的提示词:

"修复并为这张照片上色。"

处理前

处理后

使用的提示词:

"把人物变成手工钩织、可爱 Q 版的毛线玩偶。"

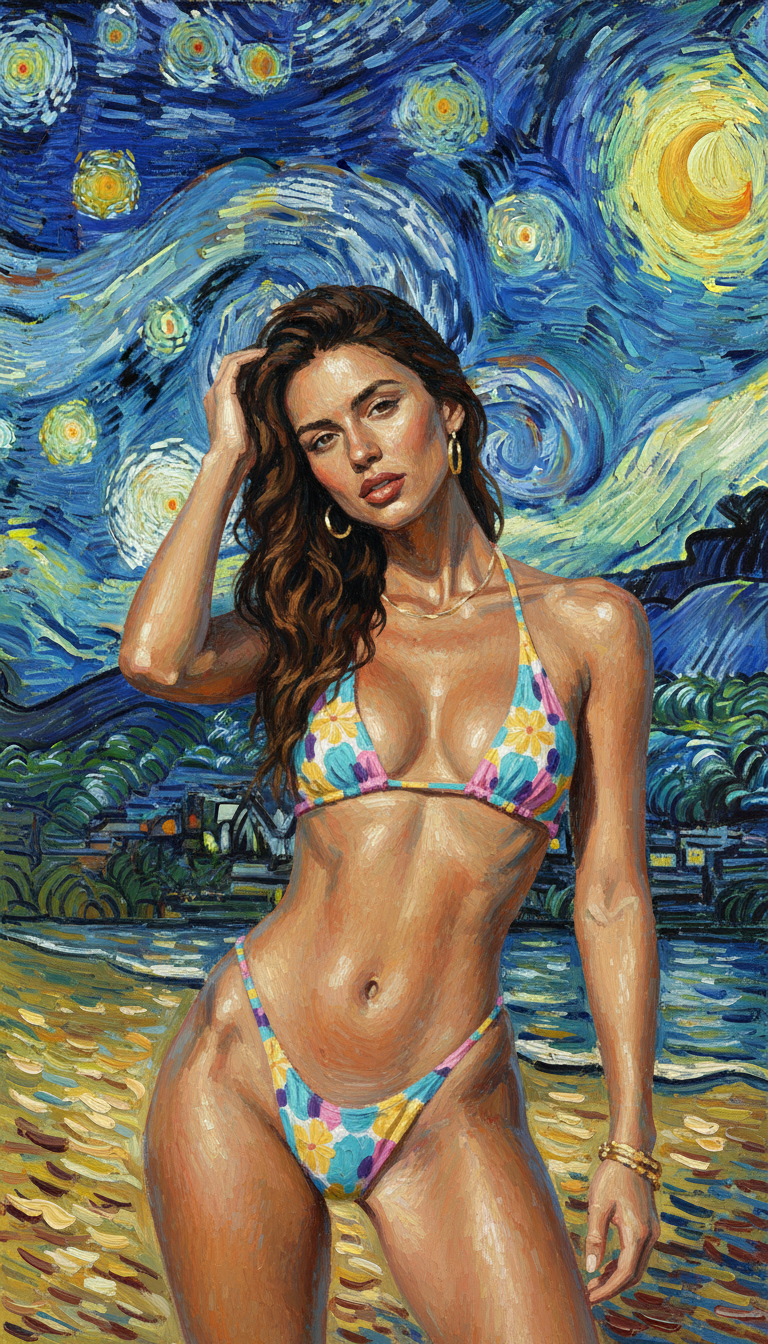

处理前

处理后

使用的提示词:

"以梵高《星夜》的画风重塑这张照片。"

处理前

处理后

使用的提示词:

"将头发颜色改为蓝色。"

处理前

处理后

使用的提示词:

"把人物变成装在包装盒中的乐高小人偶。"

滑动或使用箭头查看更多示例

什么是 Stable Diffusion?

Stable Diffusion 是开源的潜变量扩散模型,拥有社区 checkpoint 与控制插件,可重复产出可艺术指导的图像。

开源 checkpoint

运行 SDXL/SD3 基座或社区微调版,匹配品牌风格。

结构化控制

用 ControlNet、深度/姿态/边缘图锁定构图和机位。

LoRA + 风格适配

加载 LoRA 权重或风格预设,快速复刻品牌光影与质感。

可复现输出

种子、提示词权重与版本化参数,让生产输出保持一致。

如何使用 Stable Diffusion

按四步运行 SDXL/SD3 并保持可控输入。

选择模型与采样器

挑选 SDXL/SD3 或微调 checkpoint,设置采样器、步数与宽高比。

撰写正负面提示词

描述主体、风格和情绪,添加负面提示词避免伪影。

用参考图引导

上传参考图或 ControlNet 输入(姿态、深度、边缘)以锚定布局。

生成并高清放大

批量生成、对比结果,放大最佳帧用于交付。

Stable Diffusion 的核心特性

开源灵活性与生产级控制结合。

写实到风格化皆可

切换 SDXL/SD3 checkpoint,覆盖广告、概念设计与技术视觉。

精确构图控制

姿态、深度、边缘 ControlNet 让取景与透视更稳定。

友好的参考流程

组合 IP-Adapter、LoRA 与图像提示,锁定主体与风格。

正负面提示配合

平衡描述与负面提示,减少伪影并提升清晰度。

可复现的种子

保存种子与参数,复现相同活动的输出。

团队与 API 就绪

共享预设,或将 Stable Diffusion 接入自动化流程。

Stable Diffusion 常见问题

关于在生产场景使用 Stable Diffusion 的常见解答。